Valitud artiklid

WordPress 6.5 „Regina” on inspiratsioonist tulvil

Aprilli alguses avaldati WordPressi uusim versioon 6.5, mida tuntakse nimega „Regina” ja mis tutvustas mitmeid märkimisväärseid uuendusi, eriti seoses Gutenbergi leheehitajaga.

Populaarne

CloudFest 2024: AI annab riistvarale uue hingamise

Läinud nädalal istus Zone tiim lennukisse ja sööstis taaskord CloudFesti põnevasse maailma, et heita pilk veebimajutusteenuste arengusuundadele. Meie…

Zone+ WordPressi Assistent: kuidas AI abiga sekunditega veebileht luua

See aeg on läbi, mil vajadus kodulehe järele tähendas telefoniraamatust või guuglist veebidisaineri kontaktide otsimist. Tõenäoliselt üks viimase…

Aegunud PHP on aegunud PHP

Kui esimene tänapäevane PHP versioon 25 aastat tagasi avalikuks tehti, oli internet hoopis teistsugune. Nõudmised veebilehtedele olid tagasihoidlikud…

Zone on Eesti suurim veebimajutus:

25 aastat kogemust,

ligi 50 000 virtuaalserverit,

üle 145 000 domeeni.

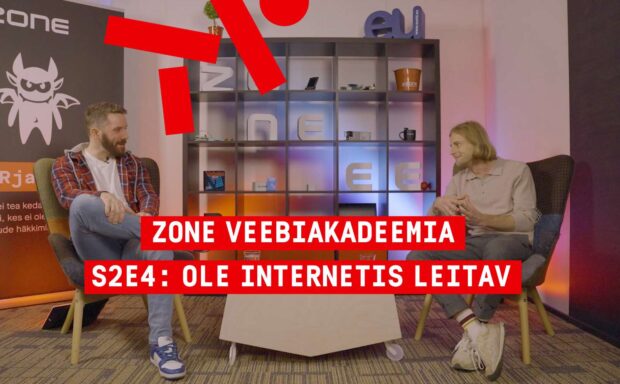

Zone Veebiakadeemia – kuidas end Internetis nähtavaks teha

Zone Veebiakadeemia uusima episoodiga hakkame tutvustama ägedaid Zone koostööpartnereid. Seekord on meil külas Nobel Digitali tootejuht ja partner…

Nutikas Pilveserver: tark lahendus e-poe ja nõudlike veebiprojektide jaoks

Nutikas Pilveserver pakub nüüdisaegset ja kulutõhusat lahendust, mis ühendab endas paindlikkuse ja võimsuse, et rahuldada kõrge külastatavusega…

Kuidas me aita(si)me tuntud veebilehtedel suurema külastatavusega toime tulla

Digimaailmas on veebilehtede kiirus ja usaldusväärsus kriitilise tähtsusega. Ikka ja jälle oleme silmitsi olukordadega, kus kliendi käsutuses olev…

Hallatud või halduseta platvorm: kumb vastab paremini sinu vajadustele?

ZoneOS platvorm on meie hallatavate teenuste alustala, sisaldades endas justkui mitme IT-spetsialisti pädevusi. Kuidas see platvorm on nii “nutikas” ja…